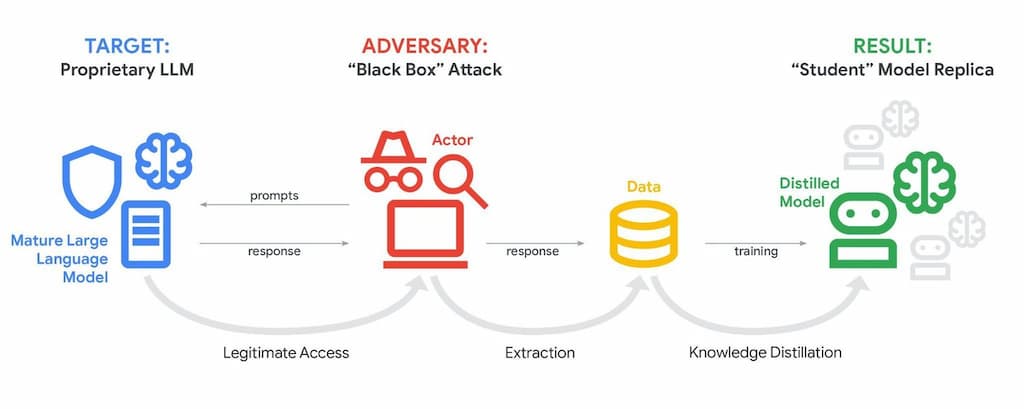

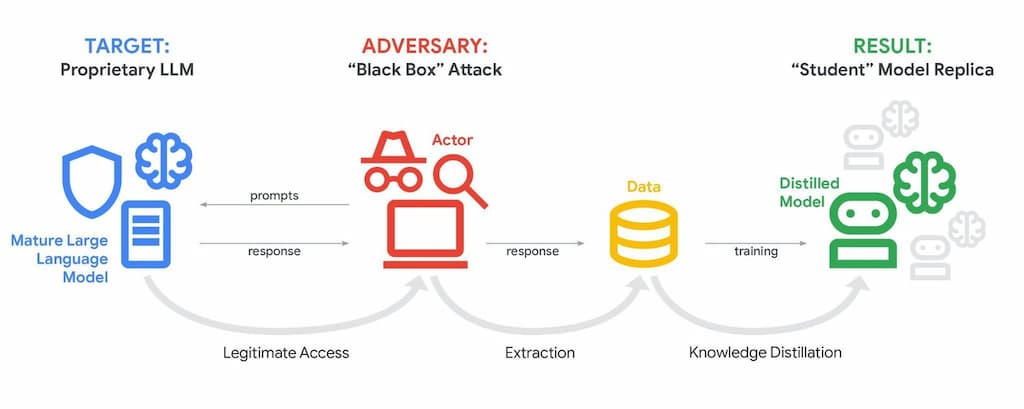

Un nuevo informe del Google Threat Intelligence Group (GTIG) ha encendido las alarmas en Silicon Valley. Según el reporte publicado este febrero de 2026, la Inteligencia Artificial ya no es solo una herramienta de ataque, sino que se ha convertido en el objetivo principal. Los hackers están utilizando técnicas de «destilación» o extracción de modelos para intentar robar la lógica interna de sistemas como Gemini y replicarlos a una fracción de su costo original (Fuente Google).

Hasta hace poco, el robo de propiedad intelectual en tecnología implicaba extraer archivos de un servidor. Hoy, la táctica es más sutil y se basa en el «bombardeo de prompts». Google detectó una campaña masiva donde atacantes realizaron más de 100,000 consultas a Gemini con un solo objetivo: observar las respuestas de razonamiento del modelo para realizar ingeniería inversa y entrenar sus propias IAs «estudiantes» con el conocimiento de la IA «maestra».

¿Cómo funciona un ataque de extracción de inteligencia?

A diferencia de un hackeo tradicional, este ataque no busca «romper» la seguridad, sino «ordeñar» el conocimiento:

- Entrada Masiva: Los atacantes utilizan scripts automatizados para enviar cientos de miles de preguntas complejas al modelo.

- Mapeo de Lógica: Analizan cómo la IA estructura sus respuestas, sus sesgos y su razonamiento lógico.

- Clonación de Bajo Costo: Utilizan esos datos para entrenar un modelo mucho más pequeño y barato que imita el comportamiento de la IA original, ahorrándose los miles de millones de dólares que costó el entrenamiento inicial.

IA-Augmented Malware: El caso HONESTCUE

El informe de Google también revela la aparición de nuevas familias de malware, como HONESTCUE, que llevan la ciberamenaza a un nivel autónomo:

- Inyección de Código en Tiempo Real: En lugar de llevar el código malicioso pregrabado (que es fácil de detectar por los antivirus), este malware hace llamadas a la API de Gemini durante su ejecución para solicitar fragmentos de código específicos según el entorno que encuentre.

- Ofuscación Dinámica: La IA ayuda al malware a reescribir su propio código cada pocas horas, volviéndolo prácticamente invisible para los sistemas de detección tradicionales basados en firmas.

Actores estatales en escena

Google ha identificado que grupos de hackers vinculados a China, Rusia, Irán y Corea del Norte están liderando este cambio de paradigma. Estos actores no solo buscan clonar modelos, sino que utilizan la IA para realizar reconocimientos de objetivos que antes tomaban semanas en cuestión de minutos, eliminando errores gramaticales en correos de phishing y creando perfiles de confianza extremadamente convincentes.

«Estamos entrando en la era de la ciberseguridad máquina-contra-máquina», advierte el reporte. La defensa ya no puede ser estática; para detener a un adversario que utiliza IA para evolucionar sus tácticas en tiempo real, las empresas deben adoptar defensas igualmente autónomas y adaptativas. Google ya ha comenzado a implementar defensas proactivas en Gemini que degradan intencionalmente la calidad de la respuesta cuando detectan patrones de extracción, protegiendo así su propiedad intelectual.