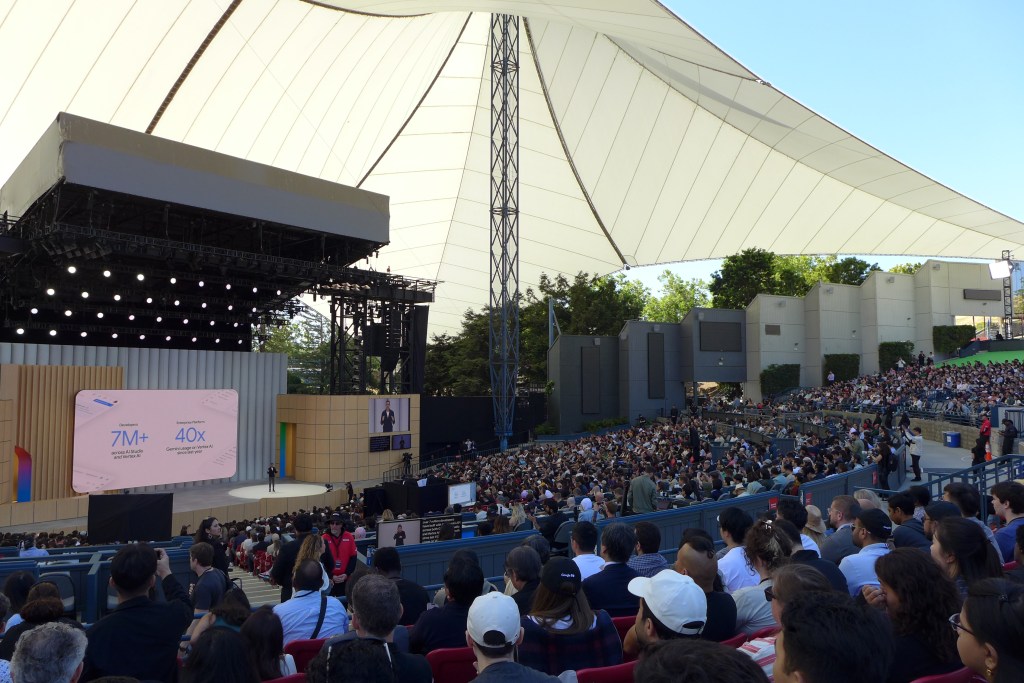

Tuve la oportunidad de asistir al Google I/O 2025, el evento anual de desarrolladores de Google, celebrado en su icónica sede central en Mountain View. Aunque el trayecto desde Berkeley implicó una combinación de tres a cuatro transportes públicos, considero que fue una alternativa preferible a enfrentar la densa hora pico del tráfico en Silicon Valley.

La organización del evento fue impecable: el proceso de acreditación resultó rápido y sencillo, y se ofrecieron excelentes opciones tanto para el desayuno como para el almuerzo, facilitando una jornada productiva y agradable.

En lugar de detallar la exhaustiva lista de anuncios —que fueron numerosos y podrían resultar abrumadores—, me centraré en un resumen de los aspectos que considero más trascendentales. Como era de esperar, la Inteligencia Artificial (IA) fue la protagonista indiscutible, con Gemini y sus diversas variantes (Pro, Flash, Nano, etc.) en el epicentro de prácticamente todas las presentaciones. El mensaje principal fue claro: Google no solo ha mejorado significativamente sus modelos de IA, sino que está acelerando su integración en todo su ecosistema de productos y abriendo caminos para la adopción por parte de terceros.

Una de las funcionalidades más destacadas fue la búsqueda inteligente, también conocida como «AI Overviews» o «AI mode». Se trata, esencialmente, de una interfaz conversacional similar a ChatGPT integrada directamente en el buscador de Google. La promesa es que los usuarios podrán realizar consultas más complejas, y Google se encargará de recopilar información de múltiples fuentes para entregar un resumen coherente. Esta evolución plantea interrogantes significativos sobre el modelo de negocio de AdSense, ya que al obtener respuestas directas, los usuarios podrían visitar menos las webs individuales (y, por ende, ver menos publicidad). Este fenómeno, en cierta medida, ya se observa con los resúmenes destacados que aparecen antes de los resultados de búsqueda tradicionales.

Una constante en la conferencia fue la presentación de los «happy paths»: demostraciones donde cada funcionalidad opera a la perfección. Sin embargo, se percibió una omisión notable en cuanto a la discusión de las posibles consecuencias negativas de estas innovaciones. Si las herramientas presentadas alcanzan la eficacia demostrada, podrían desencadenar una disrupción laboral considerable. Los riesgos para la privacidad (para aquellos que aún la valoran) y los complejos desafíos legales que Google ya enfrenta tanto en Estados Unidos como en la Unión Europea, tampoco fueron abordados en profundidad. No sugiero que Google ignore estos temas, pero en el ambiente festivo y optimista de la conferencia, parecieron quedar en un segundo plano.

Productos Destacados en Google I/O 2025

A continuación, algunos de los anuncios más relevantes:

Gemma 3n: Un modelo de IA «nano», optimizado para operar directamente en dispositivos móviles («mobile-first»). Según Google, requiere entre 2 o 3 GB de RAM, dependiendo de la versión. El objetivo es ejecutar aplicaciones de IA localmente, mejorando la privacidad del usuario y la velocidad de respuesta al no depender de la nube. Este modelo facilita tareas como transcripción de voz a texto, traducción e interacciones de voz más fluidas. Al igual que otros modelos de la familia Gemma, es de código abierto, permitiendo su descarga y personalización (fine-tuning). Más información: Introducing Gemma 3n

Gemini Nano: Similar a Gemma 3n en su capacidad para ejecutarse localmente en dispositivos con recursos limitados, Gemini Nano es un modelo cerrado. Las modificaciones están restringidas a lo que permite su API. Destaca por su «multimodalidad», es decir, la capacidad de comprender e integrar información de imágenes, texto y audio con un único modelo. Más información: Gemini Nano

Gemini Nano in Chrome: Las herramientas para desarrolladores de Chrome (DevTools) ahora integran Gemini Nano, permitiendo a los desarrolladores realizar consultas sobre el código mediante la función «Ask AI». Aunque la demostración en vivo tuvo algunos contratiempos, la intención fue clara: poder preguntar al navegador, por ejemplo, por qué un elemento HTML no está centrado o resolver dudas sobre maquetación y funcionalidad.

Gemmaverse: Este es el término acuñado por Google para referirse al ecosistema de modelos Gemma personalizados por la comunidad. Dado que Gemma es de código abierto, los usuarios pueden realizar «fine-tuning» para crear modelos derivados adaptados a necesidades específicas. Se destacaron modelos en diversos idiomas e incluso un proyecto experimental para comunicarse con delfines, mostrando un dispositivo sumergible para emitir sonidos bajo el agua. Más información: Gemmaverse

Traducción en Tiempo Real en Google Meet: Esta funcionalidad, que comenzará con el par de idiomas inglés-español y se expandirá progresivamente, promete derribar barreras lingüísticas en videollamadas. En el ejemplo mostrado, el español tenía un acento marcadamente mexicano, lo cual podría sonar menos natural para algunos hispanohablantes. No obstante, el mensaje se transmitía con claridad, y es probable que quienes necesiten un intérprete en tiempo real valoren la funcionalidad por encima de los matices del acento.

Veo 3: La nueva generación del modelo de generación de video de Google no solo mejora la calidad de imagen respecto a su predecesor, Veo 2, sino que también incorpora la generación de audio. Además de los anuncios, se instaló un stand donde los asistentes podían tomarse una foto y animarla durante 8 segundos utilizando un «prompt» interpretado por Veo 3. Desafortunadamente, la larga fila y la lenta progresión me impidieron probarlo personalmente. Más información: Generative media models at I/O 2025

Soporte para MCP (Model Context Protocol) en GenAI SDK y API de Gemini: Los MCP son esencialmente servidores que integran datos y servicios expuestos vía API con agentes de IA. Aunque es una creación de Anthropic, el protocolo es público y diversas empresas han desarrollado sus propias implementaciones. Google anunció su adopción, aunque sin ofrecer demasiados detalles, lo que sugiere que aún está en desarrollo.

Google Labs Stitch: Presentado como un diseñador de interfaces de usuario (frontends) basado en IA. El usuario describe la apariencia deseada para una aplicación, y Stitch genera el código (web o móvil) correspondiente. Aunque las demostraciones estuvieron bien, quienes hayan experimentado con herramientas de «vibe coding» o generación de código por IA sabrán que suelen tener limitaciones. De hecho, Google incluye una advertencia en letra pequeña: «Stitch can make mistakes. Please check its work.» Funciona mediante un diálogo interactivo, similar a un chat, donde Stitch produce maquetas visuales y, finalmente, los archivos fuente. Actualmente, el proceso es lento, tanto que en la demo se utilizaron proyectos pre-generados. Mi experiencia personal probando Stitch confirmó que aún presenta errores básicos; por ejemplo, un texto excedía los límites asignados y, al señalarlo, los ajustes propuestos no solucionaron el problema. Más información: Stitch with Google

Conclusión

El Google I/O 2025 fue un evento extenso, con una avalancha de productos y servicios que requerirían días para un análisis exhaustivo. Lo presentado es, en parte, prometedor. La tecnología ha progresado visiblemente en múltiples frentes. Sin embargo, especialmente en lo referente a las herramientas de generación de código, la calidad aún dista de ser la necesaria para un uso profesional fiable y sin supervisión intensiva. La IA está aquí para quedarse e integrarse profundamente, pero el camino hacia su madurez y la comprensión de todas sus implicaciones apenas comienza.

Disclaimer: El texto fue mejorado usando Google Gemini 2.5 Pro (Preview)

Por: Sebastián Bassi (Toyoko)